Sichere KI für automatisiertes Fahren

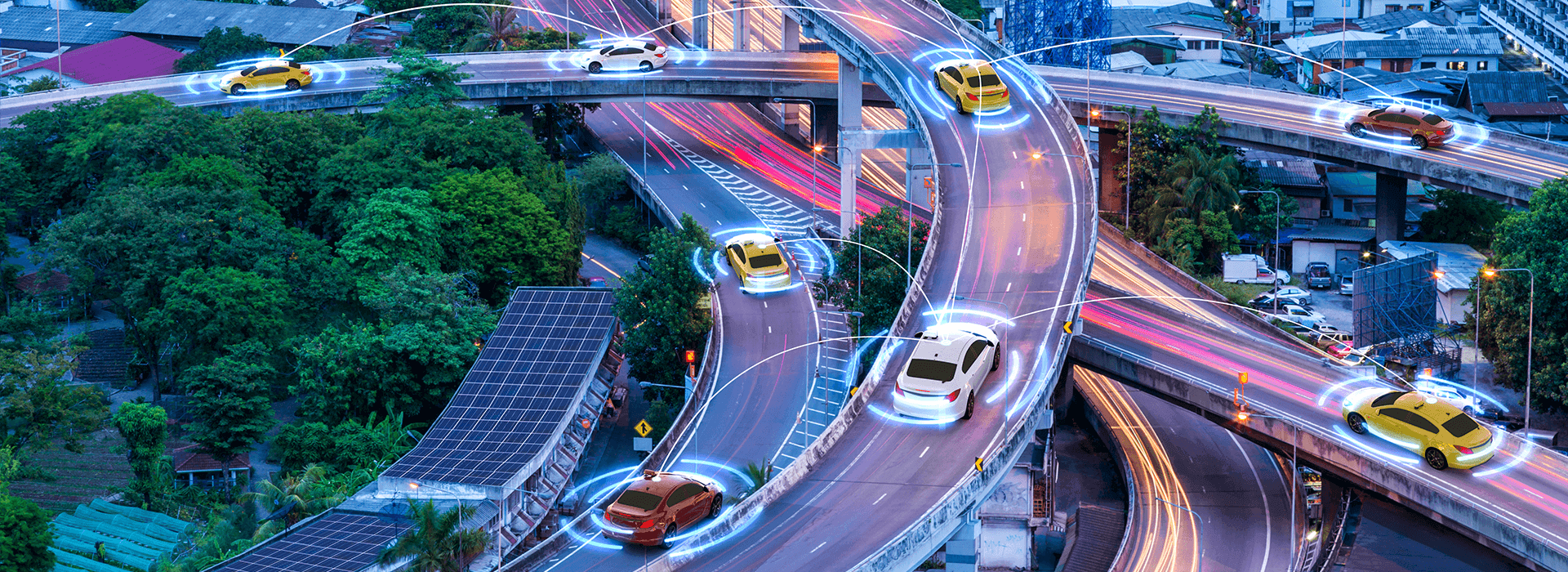

Autonome Fahrzeuge müssen in der Lage sein, ihre Umgebung wahrzunehmen und angemessen auf sie zu reagieren. Eine fehlerfreie und zuverlässige Umfelderkennung, die alle relevanten Verkehrsteilnehmer korrekt identifizieren und klassifizieren kann, ist eine Grundvoraussetzung für die Umsetzung autonomer Fahrfunktionen. Dies gilt insbesondere für die Wahrnehmung der Umwelt in komplexen städtischen Verkehrssituationen, wo zunehmend Methoden der Künstlichen Intelligenz (KI) eingesetzt werden. Solche auf maschinellem Lernen basierenden KI-Funktionsmodule werden damit zu einer Schlüsseltechnologie.

Eine der größten Herausforderungen bei der Integration dieser Technologien in hochautomatisierte Fahrzeuge ist es, die gewohnte Funktionssicherheit bisheriger Systeme zu gewährleisten, ohne dass der Fahrer im Notfall die Fahraufgabe übernehmen muss. Bestehende und etablierte Absicherungsprozesse lassen sich nicht ohne weiteres auf maschinelle Lernverfahren übertragen.

Das Projekt KI Absicherung arbeitet daran, eine stringente und nachweisbare Sicherheitsargumentation zu etablieren, damit KI-basierte Funktionsmodule (KI-Module) für das hochautomatisierte Fahren abgesichert und validiert werden können.

Die fortiss-Teams tragen zu einer Reihe von Forschungsbereichen bei, darunter:

01.07.2019 - 30.06.2022